1 dicembre 2025

Whistleblower sull’AI Act: il nuovo strumento europeo

Analisi tecnica e normativa del nuovo canale europeo per segnalazioni di violazioni AI Act con focus sulle aziende e regolamentazioni italiane

Il 24 Novembre 2025, l’Unione Europea ha ufficialmente lanciato un nuovo strumento digitale dedicato ai whistleblower, volto a facilitare la segnalazione di violazioni del Regolamento AI Act relativo all’intelligenza artificiale. Questa piattaforma rappresenta un elemento fondamentale per il monitoraggio e l’applicazione della normativa europea, offrendo canali sicuri e riservati per la comunicazione di pratiche non conformi o rischiose nell’ambito dei sistemi di IA.

Quadro normativo europeo e italiano sull’IA

L’AI Act (Regolamento UE 2024/1689) costituisce il primo corpus normativo europeo che definisce un quadro giuridico uniforme per l’intelligenza artificiale, con l’obiettivo di disciplinarne gli usi, i rischi e imporre obblighi di conformità. Il regolamento pone particolare attenzione alla trasparenza, alla sicurezza e alla tutela dei diritti fondamentali, imponendo agli operatori di mercato requisiti rigorosi in termini di valutazione del rischio e governance dei sistemi IA. In Italia, le disposizioni europee sono integrate dalla Legge 132/2025, entrata in vigore il 10 ottobre 2025. Tale legge assegna compiti specifici di vigilanza e controllo ad autorità come l’Agenzia per l’Italia Digitale (AgID) e l’Agenzia per la Cybersicurezza Nazionale (ACN). Questa normativa rappresenta un importante passo avanti nel panorama regolatorio italiano, posizionando il Paese tra le prime nazioni ad adottare un approccio sistemico e proattivo nella gestione della diffusione dell’IA.

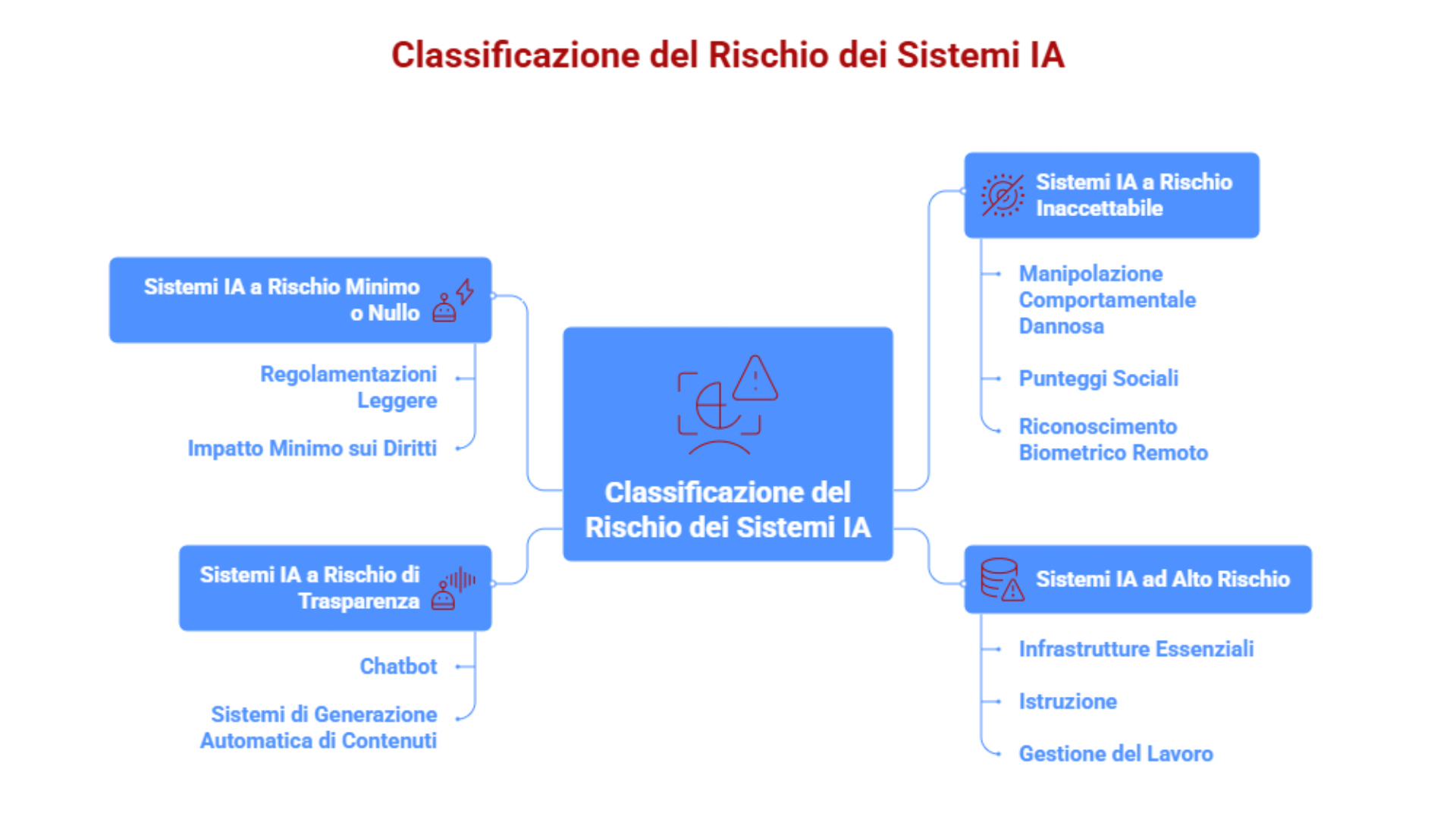

Classificazione del rischio

Una delle innovazioni chiave del regolamento è la classificazione dei sistemi IA in base al rischio associato, articolata in quattro categorie principali:

-

Sistemi IA a rischio inaccettabile: sono vietati perché considerati una minaccia diretta ai diritti o alla sicurezza delle persone. Tra questi rientrano sistemi che utilizzano manipolazione comportamentale dannosa, punteggi sociali, riconoscimento biometrico remoto finalizzato al controllo in spazi pubblici, sistemi di riconoscimento delle emozioni nei luoghi di lavoro o scolastici.

-

Sistemi IA ad alto rischio: questi sistemi possono incidere significativamente su aspetti critici come infrastrutture essenziali, istruzione, gestione del lavoro, giustizia, immigrazione e identificazione biometrica. Sono soggetti a rigidi obblighi di conformità, tra cui la valutazione rigorosa dei rischi, la garanzia della qualità dei dati, la documentazione dettagliata, la sorveglianza umana durante l’uso e robustezza tecnica.

-

Sistemi IA a rischio di trasparenza: comprendono sistemi che richiedono obblighi specifici di comunicazione all’utente finale, per esempio chatbot e sistemi di generazione automatica di contenuti. Gli obblighi impongono l’identificazione chiara di contenuti generati, come deepfake o testi sintetici, per mantenere la fiducia e prevenire informazioni ingannevoli.

-

Sistemi IA a rischio minimo o nullo: la maggioranza degli attuali sistemi IA rientrano in questa categoria e sono soggetti a regolamentazioni più leggere, con scarso o nullo impatto sui diritti fondamentali.

Obblighi di compliance per i sistemi IA ad alto rischio

Per i sistemi classificati ad alto rischio, l’AI Act prevede un articolato sistema di compliance, che include:

-

Valutazione continua e gestione sistematica del rischio lungo tutto il ciclo di vita del sistema.

-

Tenuta di una documentazione tecnica esaustiva, che faciliti la valutazione di conformità da parte delle autorità competenti.

-

Assicurazione di adeguate misure di sorveglianza umana per prevenire decisioni automatizzate errate o pregiudizievoli.

-

Implementazione di misure di robustezza, sicurezza informatica e accuratezza del sistema.

-

Gestione strutturata e tempestiva di incidenti e malfunzionamenti post-commercializzazione.

-

Trasparenza e comunicazione chiara agli utenti finali sull’uso e le caratteristiche del sistema di IA.

Governance e applicazione del regolamento

Il modello di governance previsto è multilivello: l’Ufficio europeo per l’intelligenza artificiale è responsabile di coordinare entro un quadro comune le attività di vigilanza, supportando e lavorando in collaborazione con le autorità nazionali degli Stati membri. Questo approccio garantisce uniformità nell’applicazione della normativa e consente di intervenire con tempestività in caso di inosservanza o criticità rilevate.

Regole per i modelli di IA per finalità generali (GPAI)

L’AI Act dedica attenzione particolare ai modelli di IA per finalità generali, come quelli impiegati nella generazione di testi, immagini, codici o suoni, che possono comportare rischi sistemici a causa della loro capacità e diffusione. Dal 2 agosto 2025 sono in vigore disposizioni specifiche che regolano la loro offerta e utilizzo, imponendo trasparenza, garanzie sul trattamento dei dati e gestione dei diritti d’autore, in linea con i principi di innovazione responsabile.

Funzionalità tecniche dello strumento whistleblower per l’AI Act

Lo strumento per i whistleblower è una piattaforma digitale implementata dall’Ufficio europeo per l’intelligenza artificiale, progettata per garantire:

-

La possibilità di segnalare violazioni del Regolamento AI Act in modo sicuro, riservato e anonimo.

-

L’accettazione di segnalazioni in tutte le lingue ufficiali dell’UE, con caricamento di documentazione probatoria in vari formati.

-

L’utilizzo di tecnologie di crittografia certificata per tutelare l’identità degli informatori e la riservatezza delle comunicazioni.

-

Una casella di posta integrata per il dialogo bidirezionale tra informatore e autorità, che consente aggiornamenti sull’iter della segnalazione senza rivelare l’identità del segnalante. Queste caratteristiche rispondono all’esigenza di assicurare un canale efficiente e conforme alle normative sulla privacy, valorizzando la partecipazione attiva di individui e organizzazioni nella corretta applicazione del regolamento.

Ambito di applicazione e segnalazioni ammesse

Il tool si rivolge in primis ai fornitori di modelli di IA per finalità generali e ai gestori di sistemi IA classificati ad alto rischio secondo il Regolamento AI Act. Tuttavia, è aperto a tutte le parti interessate che desiderino segnalare pratiche che possono compromettere aspetti quali:

-

La sicurezza e l’affidabilità dei prodotti basati su IA.

-

La tutela della privacy e dei dati personali.

-

Il rispetto dei diritti fondamentali, inclusa la non discriminazione.

-

La conformità ai requisiti legali applicabili nei diversi settori di impiego.

In Italia, questa piattaforma integra i meccanismi di controllo istituiti dalle autorità nazionali, facilitando un sistema di governance articolato e multilivello che risponde alle esigenze di un mercato in rapida evoluzione.

Ruolo del whistleblower tool nel mercato italiano dell’IA

Il mercato italiano dell’IA nel 2025 registra una crescita significativa, con un valore stimato di oltre 1,2 miliardi di euro nell’ultimo anno e un tasso di adozione in aumento soprattutto tra le grandi imprese. In questo contesto, l’implementazione di un sistema di whistleblowing efficiente rappresenta un elemento chiave per accompagnare questo sviluppo, offrendo maggiore sicurezza e affidabilità nei processi di innovazione. Le aziende italiane, impegnate nell’integrazione dei sistemi di IA sia in ambito industriale che nei servizi, sono chiamate a conformarsi a standard più stringenti, e lo strumento contribuisce a far emergere tempestivamente situazioni di non conformità, permettendo interventi correttivi rapidi e supportando la creazione di un ambiente di mercato più trasparente e competitivo.

Tuttavia, affinché questo meccanismo funzioni in modo effettivo, un aspetto cruciale riguarda la protezione degli informatori. La normativa europea prevede una protezione giuridica formale contro eventuali ritorsioni a partire dal 2 agosto 2026, mentre prima di tale data la tutela si fonda principalmente sulla riservatezza e sull’anonimato garantiti dalle soluzioni tecniche e procedurali della piattaforma. In Italia, dove la cultura del whistleblowing si sta progressivamente affermando, l’applicazione di queste garanzie assume rilievo particolare e l’integrazione tra il Regolamento AI Act e la normativa nazionale favorisce un quadro di riferimento solido, contribuendo a incentivare la partecipazione degli stakeholder alla vigilanza preventiva e continua dei sistemi IA.

Nel complesso, il lancio dello strumento per i whistleblower dell’AI Act rappresenta un progresso significativo nel controllo regolatorio e nella governance etica dell’intelligenza artificiale a livello europeo, con effetti rilevanti per l’Italia. La piattaforma si configura come uno strumento tecnico-normativo essenziale per garantire che lo sviluppo e l’adozione dell’IA avvengano nel rispetto dei diritti fondamentali e della sicurezza e, per le imprese italiane, l’introduzione di questa nuova modalità di segnalazione significa integrare processi di compliance più efficaci, migliorare la trasparenza e contribuire a un ecosistema digitale più affidabile. Nel contesto normativo e tecnologico in rapido mutamento, questo strumento facilita un approccio proattivo e coordinato tra istituzioni, imprese e cittadini.

Fonti:

-

ANSA Tecnologia, “L’Ue lancia uno strumento per segnalare violazioni dell’AI Act”, 24 novembre 2025. https://www.ansa.it/canale_tecnologia/notizie/tecnologia/2025/11/24/lue-lancia-uno-strumento-per-segnalare-violazioni-dellai-act_1c1d1a38-967c-4bf2-918f-605618db29dc.html

-

Commissione europea, DG CNECT, “Strumento informatore AI Act”, sito ufficiale Digital Strategy. https://digital-strategy.ec.europa.eu/it/policies/ai-act-whistleblower-tool

-

Rappresentanza in Italia della Commissione europea, “La Commissione vara lo strumento di segnalazione (whistleblower tool) per il regolamento sull’IA”, 24 novembre 2025. https://italy.representation.ec.europa.eu/notizie-ed-eventi/notizie/la-commissione-vara-lo-strumento-di-segnalazione-whistleblower-tool-il-regolamento-sullia-2025-11-24_it

-

CADE Project, “EU Commission launches confidential whistle blower tool for reporting AI Act violations”, 24 novembre 2025. https://cadeproject.org/updates/eu-commission-launches-confidential-whistle-blower-tool-for-reporting-ai-act-violations/

Marta Magnini

Digital Marketing & Communication Assistant in Aidia, laureata in Scienze della Comunicazione e appassionata delle arti performative.

In Aidia sviluppiamo soluzioni software basate su IA, soluzioni di NLP, Big Data Analytics e Data Science. Soluzioni innovative per ottimizzare i processi ed efficientizzare i flussi di lavoro. Per saperne di più, contattaci o inviaci una mail a info@aidia.it.