13 gennaio 2026

IA agentica e governance

Come preparare processi, dati e conformità nell'era post AI Act

L’intelligenza artificiale sta attraversando una fase di trasformazione profonda: dai modelli generativi isolati si passa rapidamente verso sistemi agentici capaci non solo di rispondere ma di agire, coordinare strumenti, accedere a dati e prendere decisioni operative entro limiti definiti. Mark Minevich, stratega IA, definisce questo passaggio epocale: “Nel 2026, l’intelligenza artificiale si muoverà con noi come co-lavoratore costante, mentre sistemi multi-agente gestiranno flussi di lavoro interi una volta controllati dagli umani”. In questo scenario, con l’AI Act e il Digital Omnibus a ridisegnare confini, responsabilità e obblighi per aziende e pubblica amministrazione europea, la domanda chiave non è più “qual è il modello migliore?”, ma “come preparo i miei processi, i miei dati e la mia governance per l’intelligenza artificiale agentica?”. Gartner prevede che oltre il 40% dei progetti di intelligenza artificiale agentica verrà cancellato entro fine 2027 per costi crescenti, valore aziendale incerto e controlli dei rischi inadeguati.

Dal 2026, l’intelligenza artificiale come partner operativo quotidiano

Le previsioni per il 2026 delineano uno scenario di massiccia accelerazione, ma anche di selezione darwiniana tra progetti IA. Secondo Minevich, “i vincitori non saranno gli “adottanti di IA”, ma coloro che impareranno a trattare l’IA come un collega alla pari”. Ogni dipendente avrà un assistente IA dedicato per mansioni HR, operations e guida sulle performance in tempo reale, non semplici chatbot per FAQ ma collaboratori digitali integrati nei flussi di lavoro. Assunzioni e promozioni si baseranno sempre più su alfabetizzazione IA, competenze di automazione e intuizione nel design dei workflow, con il 30% delle grandi imprese che avvierà programmi di formazione per la fluency IA secondo le previsioni di Forrester. Sistemi multi‑agente composti da numerosi agenti specializzati collaboreranno su ottimizzazione della supply chain, pipeline di R&D e percorsi di cura del paziente, ma Forrester avverte anche di un rischio di gravi violazioni agentiche in assenza di un’adeguata orchestrazione.

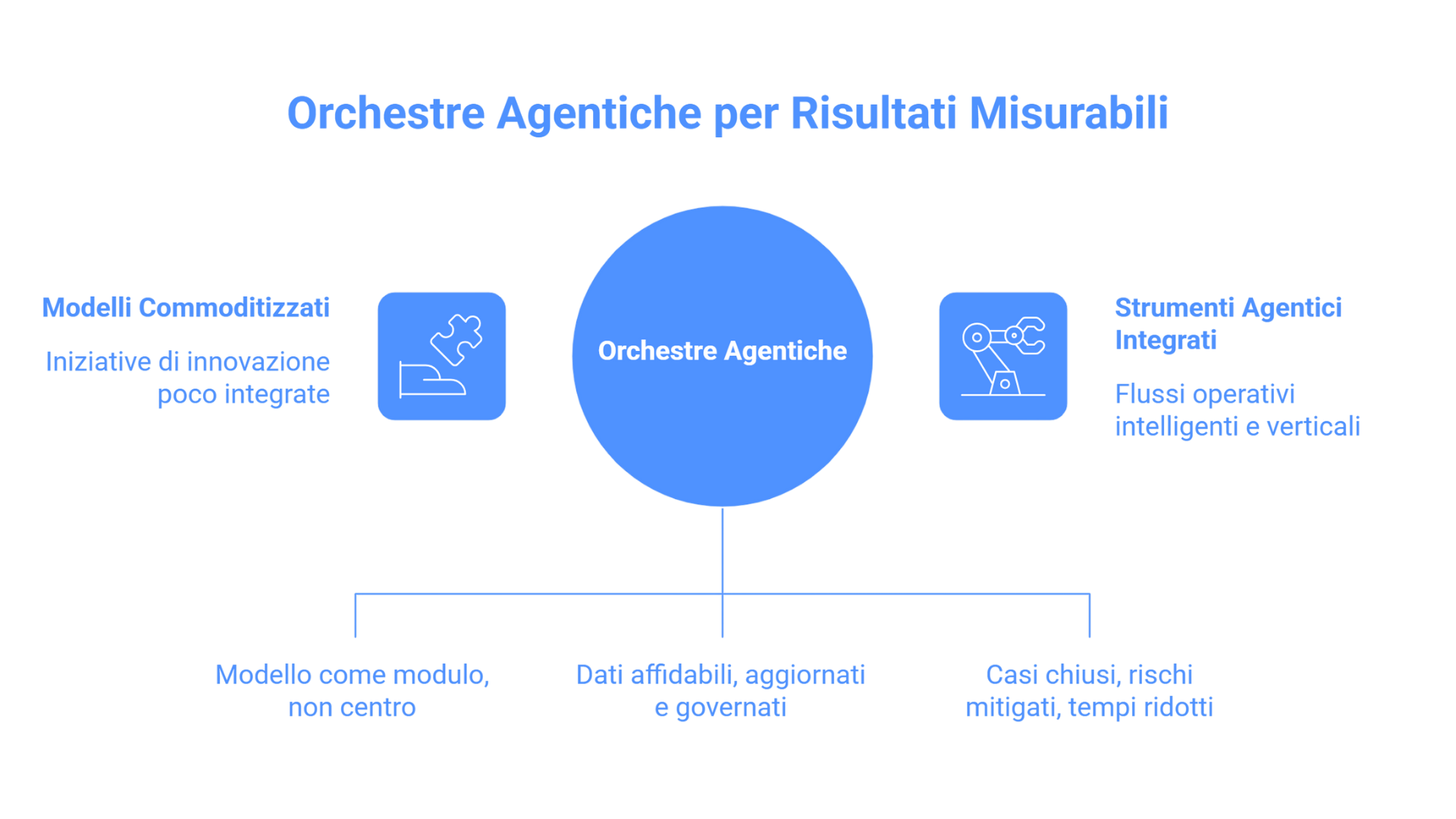

Cambio strategico: da modelli commoditizzati a orchestre agentiche

Negli ultimi due anni molte organizzazioni hanno sperimentato chatbot, assistenti virtuali e casi d’uso di generazione contenuti, spesso confinati in POC o iniziative di innovazione poco integrate nei flussi principali. L’intelligenza artificiale agentica rappresenta un cambio di paradigma: non più un modello che produce testi o suggerimenti, ma insiemi di agenti software che osservano un contesto, decidono quali azioni intraprendere e le eseguono su sistemi reali – CRM, ERP, sistemi di ticketing, repository documentali, API di terze parti – raccogliendo automaticamente informazioni per report di audit, analizzando e instradando segnalazioni di whistleblowing, monitorando log ed eventi per individuare pattern anomali e gestendo attività operative in tempo quasi reale.

In parallelo, il mercato dei modelli sta vivendo una progressiva commoditizzazione: grandi modelli linguistici di grandi dimensioni, open source e proprietari, sono sempre più accessibili, interoperabili e difficili da distinguere nella pratica quotidiana, e la vera differenza competitiva non sta più nell’avere il modello più grande, ma nel saperlo trasformare in strumenti agentici integrati con i sistemi core, i dati aziendali e gli obiettivi operativi. Per chi guida organizzazioni complesse, piccole e medie imprese regolamentate, gruppi industriali e pubblica amministrazione, questo significa:

-

progettare catene operative e architetture in cui il modello è solo un modulo e non il centro della strategia;

-

collegare l’intelligenza artificiale a fonti dati affidabili, aggiornate e governate evitando intelligenza artificiale ombra e iniziative non presidiate;

-

misurare l’impatto in termini di casi chiusi, rischi mitigati e tempi ridotti, non solo in accuratezza o qualità del testo.

Il valore si sposta dal “modello che sa fare molte cose” alla capacità di costruire strumenti verticali, agenti specializzati e flussi operativi intelligenti che portano risultati misurabili su problemi concreti come conformità normativa, gestione del rischio, governance informatica, processi di segnalazione e sicurezza dei dati.

IA fisica: dalla sperimentazione alla produzione nel manifatturiero

Le carenze di manodopera qualificata sono diventate strutturali: tecnici e operatori esperti scarseggiano a livello mondiale e, nel 2026, i produttori si rivolgeranno all’intelligenza artificiale non solo per risparmiare costi ma per sopravvivere. L’IA potenzierà i lavoratori qualificati automatizzando compiti ripetitivi, migliorando la sicurezza e ottimizzando la filiera; Nvidia parla di “era dell’Intelligenza Artificiale fisica”, in cui robot umanoidi come Tesla Optimus, Figure e Agility passeranno da dimostrazioni a progetti pilota commerciali mirati in magazzini e fabbriche, con distribuzione di migliaia o decine di migliaia di unità. Mentre molte industrie lottano a quantificare i ritorni sull’intelligenza artificiale, il manifatturiero offre ambienti controllati dove i risultati sono dimostrabili: i tassi di difetti caleranno, la produzione aumenterà e i cicli si ridurranno.

Governance estesa: AI Act, sicurezza e sovranità digitale

Il quadro regolatorio europeo è diventato il contesto inevitabile per qualsiasi iniziativa di intelligenza artificiale: AI Act, Digital Omnibus, sovranità digitale, whistleblowing; l’intelligenza artificiale agentica porta queste questioni al centro dell’operatività quotidiana. L’AI Act introduce categorie di rischio con obblighi stringenti di trasparenza, documentazione, valutazione e controllo per i sistemi ad alto rischio, mentre cresce la necessità di dimostrare chi ha fatto cosa, quando e sulla base di quali dati e logiche, soprattutto in processi sensibili come risorse umane, finanza, pubblica amministrazione, giustizia e sanità; al tempo stesso, Digital Omnibus ed evoluzione del GDPR richiedono particolare attenzione a basi giuridiche, minimizzazione, gestione dei consensi, diritti di accesso e opposizione.

L’introduzione di agenti autonomi accentua tutte queste questioni: un conto è un assistente che produce un testo da revisionare, un altro è un agente che prende decisioni operative o suggerisce azioni che incidono su diritti, reputazione e conformità.

Su questo sfondo, identità e sicurezza diventano il nuovo campo di battaglia: Minevich prevede che nel 2026 “l’identità, non i dati, diventerà il focus centrale della criminalità e della sicurezza”, con deepfake, impersonificazione e dirottamento degli agenti destinati a crescere rapidamente fino alla probabilità di una grave violazione pubblica di intelligenza artificiale agentica nello stesso anno. Le imprese avranno bisogno di firewall per intelligenza artificiale, architetture progettate con sicurezza intrinseca, framework di governance degli agenti e crittografia resistente al quantum, mentre il browser tenderà a diventare il vero sistema operativo aziendale, con la conseguenza di trasformarsi nel bersaglio principale degli attacchi e di richiedere modelli di sicurezza zero-trust integrati direttamente al suo interno.

Nel frattempo la sovranità digitale assume una connotazione ancora più strategica quando si parla di agenti che operano su dati sensibili e sistemi critici: non conta solo dove risiede il modello, ma chi controlla l’intera catena operativa, dagli orchestratori ai connettori, dai repository dati ai sistemi di logging e monitoraggio. McKinsey prevede che la spesa per infrastrutture di intelligenza artificiale continui a crescere verso un valore proiettato di 7 trilioni di dollari, con investimenti in intelligenza artificiale sovrana a 100 miliardi a livello globale nel 2026. Per pubblica amministrazione e organizzazioni regolamentate questo si traduce nel preferire stack trasparenti e auditabili, soluzioni europee o open source che riducano dipendenze da pochi grandi fornitori extra-Unione Europea, e architetture portabili che evitino fenomeni di lock-in al fornitore.

Ripensare processi e dati per l’era agentica

Per passare da sperimentazioni isolate a un utilizzo strutturale dell’intelligenza artificiale agentica non basta incorporare un modello nei sistemi esistenti: serve un lavoro di riprogettazione organizzativa e tecnologica che permetta agli agenti di agire in modo sicuro, controllabile e conforme. Questo significa mappare i processi end-to-end individuando colli di bottiglia, attività ripetitive e passaggi manuali che consumano tempo e generano rischio operativo, capire quali decisioni possono essere supportate o parzialmente automatizzate mantenendo il decisore umano dove serve giudizio, definire “zone di autonomia” in cui stabilire con chiarezza cosa un agente può fare in automatico, cosa deve sottoporre a revisione umana e cosa non può fare in alcun caso, modellando policy e limiti operativi direttamente nei flussi di lavoro e nelle integrazioni tecniche, e preparare i dati per un uso agentico migliorandone qualità, struttura e accessibilità affinché gli agenti possano consultarli in modo controllato.

Governance operativa

Quando gli agenti iniziano a prendere decisioni operative, la governance smette di essere un tema astratto e diventa un requisito quotidiano: secondo Gartner, i tre motivi principali del fallimento dei progetti di intelligenza artificiale agentica sono: costi elevati con proprietà limitata; valore aziendale poco chiaro; e controlli del rischio inadeguati. Una governance efficace si fonda sulla tracciabilità degli agenti, su responsabilità chiare e su cicli di revisione continua. Ogni azione significativa dell’agente richiede una registrazione dettagliata e strutturata: chi l’ha eseguita (identificativo univoco dell’agente), cosa ha compiuto, su quali dati ha operato, con quale esito e in base a quale input o istruzione. Tali log non servono solo alla compliance, ma abilitano audit interni rapidi, risposte puntuali alle autorità e cicli di miglioramento continuo. Parallelamente, occorre definire con chiarezza i ruoli umani di responsabilità: chi configura gli agenti, chi approva le policy operative, chi supervisiona il loro funzionamento quotidiano e chi ha l’autorità per sospensioni o modifiche. Gli agenti devono inoltre essere monitorati nel tempo attraverso indicatori chiave di performance, tassi di errore, casi eccezionali e feedback interni, così da aggiornare in modo iterativo prompt, policy, integrazioni e logiche decisionali, rendendo la governance un processo dinamico e data-driven.

Come iniziare in modo concreto e sicuro

Molte organizzazioni si chiedono da dove partire, senza paralizzarsi per paura dei rischi ma anche senza esporsi in modo imprudente. Un percorso realistico prevede una valutazione congiunta di processi e rischi, identificando due o tre aree ad alto valore e tracciabilità, come gestione segnalazioni, richieste interne o monitoraggio conformità, in cui l’intelligenza artificiale agentica può portare benefici misurabili, valutando i rischi associati e classificando i possibili sistemi secondo le categorie dell’AI Act. Si passa poi alla progettazione di un primo “circuito agentico controllato”, cioè un flusso in cui un agente opera all’interno di limiti chiari, con supervisione umana, registri completi e metriche definite sin dall’inizio, coinvolgendo fin da subito funzioni come conformità normativa, informatica, sicurezza, risorse umane o legale per evitare progetti imposti dall’alto o percepiti come “scatole nere”; si raccolgono dati, feedback, incidenti e casi di successo e li si usa per migliorare agenti, policy e integrazioni, estendendo progressivamente l’uso dell’intelligenza artificiale agentica ad altri processi e mantenendo coerenza di governance, standard tecnici e documentazione.

Verso un nuovo modello operativo umano-agente

L’IA agentica non sostituisce le persone, ma cambia il modo in cui si lavora: dal lavoratore che usa uno strumento al team ibrido umano-agente che co-esegue processi complessi. Forrester evidenzia che “la scarsa alfabetizzazione all’intelligenza artificiale erode la fiducia e frena l’adozione, con il 21% dei decisori che cita esperienza dei dipendenti e preparazione come barriera”, e in questo nuovo modello operativo le competenze evolvono con meno tempo dedicato ad attività ripetitive e più a decisioni di merito, interpretazione dei risultati, gestione delle eccezioni e miglioramento dei processi, mentre risorse umane e team dedicati alle persone evolvono da semplici amministratori a “architetti strategici di performance umana potenziata dall’intelligenza artificiale”.

Per le organizzazioni che sapranno cogliere questa transizione, il vantaggio competitivo non sarà solo tecnologico ma strutturale: tempi decisionali ridotti, migliore controllo del rischio, capacità di adattarsi rapidamente a nuovi requisiti regolatori e di mercato; come conclude Minevich, il 2026 separerà i leader dell’intelligenza artificiale che padroneggiano orchestrazione multi-agente, governance e collaborazione umano-intelligenza artificiale da quelli che restano bloccati nelle sperimentazioni, e per farlo è essenziale integrare fin da subito tre dimensioni: tecnologia agentica; governance e conformità normativa; visione strategica su dati e sovranità digitale. Le aziende che stabiliscono una governance forte in anticipo si muoveranno più velocemente con meno sorprese, mentre chi non lo fa rischia di rientrare in quel 40% di progetti cancellati previsto da Gartner.

Fonti:

-

AI4Business, “AI agentica, perché il futuro è negli strumenti più che nei modelli” (5 Gennaio 2026) https://www.ai4business.it/intelligenza-artificiale/ai-agentica-perche-il-futuro-e-negli-strumenti-piu-che-nei-modelli/

-

Forbes, “Agentic AI Takes Over — 11 Shocking 2026 Predictions” (31 Dicembre 2025, aggiornato 7 Gennaio 2026) https://www.forbes.com/sites/markminevich/2025/12/31/agentic-ai-takes-over-11-shocking-2026-predictions/

-

Gartner, “Gartner Predicts Over 40% of Agentic AI Projects Will Be Canceled by End of 2027” (25 Giugno 2025) https://www.gartner.com/en/newsroom/press-releases/2025-06-25-gartner-predicts-over-40-percent-of-agentic-ai-projects-will-be-canceled-by-end-of-2027

-

Forrester, “Predictions 2026: AI Moves From Hype To Hard Hat Work” (27 Ottobre 2025) https://www.forrester.com/blogs/predictions-2026-ai-moves-from-hype-to-hard-hat-work/

-

Gartner, “AI’s Influence Runs Deeper Than You Think — 2026 Gartner Strategic Predictions Explain Why” https://www.gartner.com/en/articles/strategic-predictions-for-2026

Marta Magnini

Digital Marketing & Communication Assistant in Aidia, laureata in Scienze della Comunicazione e appassionata delle arti performative.

In Aidia sviluppiamo soluzioni software basate su IA, soluzioni di NLP, Big Data Analytics e Data Science. Soluzioni innovative per ottimizzare i processi ed efficientizzare i flussi di lavoro. Per saperne di più, contattaci o inviaci una mail a info@aidia.it.